Tutorial hadoop - Guia prático de um cluster com 3 computadores

Seu chefe disse que para aumentar o lucro da empresa é necessário criar um buscador de site (ex.: Google), ou seja, fazer uma pesquisa de forma eficiente em um arquivo com 10GB de tamanho por exemplo. Então conheça na prática como a ferramenta hadoop pode lhe ajudar.

[ Hits: 37.949 ]

Por: Ronaldo Borges em 21/12/2015 | Blog: https://www.facebook.com/ronyjah1

Descrição

Descrição resumida das principais ferramentas de cluster hadoop:

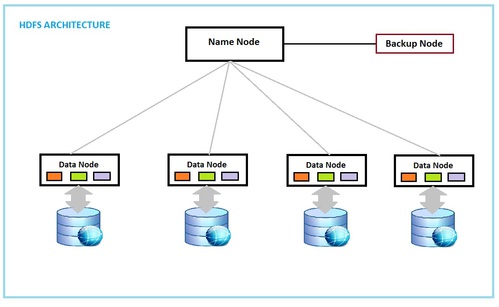

O sistema hadoop realiza duas tarefas básicas, dividir o arquivo a ser computado entre os nodos usando um sistema de arquivo próprio (ferramenta HDFS) e a outra tarefa é executar a aplicação nos nodos (ferramenta MapReduce ou Yarn). Nesta primeira parte trataremos da configuração do serviço HDFS.

Recursos necessários para montar o cluster:

- 1x computador mestre para rodar o namenode*

- 2x computadores escravos para datanode**

Obs.: O sistema também funcionará apenas com dois computadores (um namenode e um datanode).

* namenode é o principal elemento do sistema de arquivos do cluster, é o gerenciador do sistema de arquivos, monitora a saúde dos computadores escravos (datanodes), medindo os recursos de disco rígido e memória disponível. Tem a função de fragmentar o metadado em blocos e repassar para os datanotes. Lembrando que para aumentar a robustez contra falha nos nodos, os blocos sao replicados por 3 (configuração padrão).

Obs.: nos meus testes eu deixei em torno de 10 GB disponíveis no HD. Se não configurado, o hadoop irá alocar automaticamente o espaço disponível no seu HD para montar o sistema de arquivo DFS.

** datanode - o sistema criado pelo namenode é chamado HDFS. Ele basicamente cria blocos de 128 MB (config default) entre os computadores datanode. Conforme o tamanho do metadado a ser processado, mais blocos serão criados. Para aumentar a robustez do sistema o namenode replicará os dados do metadado aos datanodes do cluster.

Na imagem abaixo é possível ver a ilustração de sistema de arquivos HDFS. O metadado a ser computado por uma aplicação é dividido pelo namenode em blocos de 128 ou 64 MB enviados aos datanodes. Cada cor simboliza um bloco. As cores iguais entre os nodos representam a replicação dos dados para proteger a aplicação contra possíveis falhas em alguns dos nodos e a aplicação continue executando.

Este tutorial, foi implementado em sistema operacional Linux. Nas próximas paginas iremos descrever os principais componentes de configuração do cluster, arquivos de configuração, iniciação dos serviços e o exemplo de execução de uma aplicação contadora de palavras no cluster.

2. Configurando o ambiente nos computadores para receber o cluster hadoop

3. Instalação e configuração do hadoop

4. Iniciando o cluster hadoop

5. Testando o cluster Hadoop

6. Possíveis problemas

Tutorial - Aplicação em C para transferência de arquivo usando socket TCP e Thread

Conexões Wireless com DHCP no Slackware - Configuração à moda antiga

Monitorando Rede com Zabbix no Debian 7

Configurações Básicas no CentOS 7

SQUID com autenticação e permissões por grupos do Active Directory e relatórios com SARG

WebHTB - Controle de banda de internet

Para fins de estudo e conhecimento o cenário proposto pelo artigo é valido. Em ambiente real não. Só pelo overhead gerado pelas tecnologias citadas mais a infraestrutura, a aplicação desta solução não vale a pena. O ecossistema Haddop deve preferencialmente ser usado quando REALMENTE o desafio de coleta, processamento e análise de dados demandam artilharia pesada! Deixo como sugestão a leitura desta apresentação e veja como problemas similares com um volume muito mais brutal de dados foram analisados usando apenas LINUX! http://slides.com/ronie/fbp_2015#/

[2] Comentário enviado por Lwkas em 28/12/2015 - 17:35h

Muito bom!

Fico agradecido por seu elogio, especialmente se este artigo for útil.

Cara, parabéns. Ótimo post de material riquíssimo.

Patrocínio

Destaques

Artigos

Berry Bank: Criando um Banco Digital Gamificado para seus Filhos com Gentoo, Flask e Tailscale

Papagaiando o XFCE com temas e recursos

Dicas

Instale o DOOM Retro no Gentoo facilmente via Overlay

Steam (Flatpak) rodando jogos em partição NTFS

O dock Plank + U-Launcher deixam qualquer desktop mais produtivo

Tópicos

Instalar Linux em notebook Sony Vaio VPCEG13EB (17)

Alguém tem que acabar com ANATEL!!! (10)

O que você está ouvindo agora? [2] (229)

Top 10 do mês

-

Xerxes

1° lugar - 129.078 pts -

Fábio Berbert de Paula

2° lugar - 59.363 pts -

Buckminster

3° lugar - 27.907 pts -

Sidnei Serra

4° lugar - 21.261 pts -

Alberto Federman Neto.

5° lugar - 20.932 pts -

Alessandro de Oliveira Faria (A.K.A. CABELO)

6° lugar - 20.013 pts -

Mauricio Ferrari (LinuxProativo)

7° lugar - 19.760 pts -

edps

8° lugar - 18.897 pts -

Daniel Lara Souza

9° lugar - 18.848 pts -

Andre (pinduvoz)

10° lugar - 17.137 pts