Ceph - Uma Plataforma de Armazenamento Distribuído

Ceph é SDS (Software-Defined Storage - traduzido: Armazenamento Definido por Software) de código aberto, onde implementa o armazenamento de objetos em um único cluster de computador distribuído e fornece 3 interfaces em 1: armazenamento em nível de Objeto, Bloco e Arquivo. O Ceph visa principalmente a operação totalmente distribuída sem um único ponto de falha, escalonável até o nível de exabyte.

[ Hits: 14.222 ]

Por: Daniel Lara Souza em 20/09/2020 | Blog: http://danniel-lara.blogspot.com/

Instalação

Vamos efetuar o deploy utilizando o cephadm, uma maneira fácil de configurar e gerenciar.

O Cephadm implanta e gerencia um cluster Ceph conectando-se a hosts do daemon do gerenciador via SSH para adicionar, remover ou atualizar os contêineres daemon Ceph. Ele não depende de configuração externa ou ferramentas de orquestração como Ansible, Rook ou Salt.

Cephadm gerencia todo o ciclo de vida de um cluster Ceph. Ele começa inicializando um minúsculo cluster Ceph em um único nó (um monitor e um gerenciador) e, em seguida, usa a interface de orquestração para expandir o cluster para incluir todos os hosts e provisionar todos os serviços e daemons Ceph. Isso pode ser executado por meio da interface de linha de comando (CLI) ou painel (GUI) do Ceph.

Cephadm é novo na versão Octopus v15.2.0 e não oferece suporte a versões anteriores do Ceph.

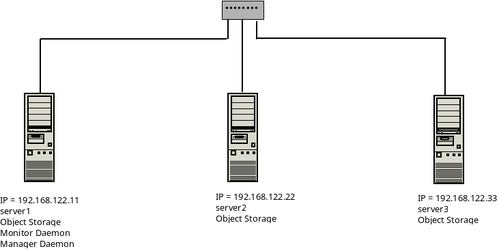

Uma visão geral do cluster

Vamos configurar NTP nos 3 servers, use essa mesma configuração para eles.Instale o Chrony:

# dnf -y install chrony

Edita o arquivo /etc/chrony.conf e deixei-o assim:

pool b.st1.ntp.br iburst

pool c.st1.ntp.br iburst

pool a.ntp.br iburst

pool b.ntp.br iburst

pool c.ntp.br iburst

Salve o arquivo e inicie o serviço

# systemctl enable --now chronyd

Agora vamos instalar o Podman em todos os servers, pois o Ceph irá rodar em contêineres:

# dnf install podman -y

Vamos ajustar a versão do Python para 3.6. Instale em todos os servers e ajuste o mesmo:

# dnf module -y install python36

# alternatives --config python

Agora no server 1, instale o cephadm:

# dnf -y install cephadm

Crie o diretório "ceph" no /etc:

# mkdir /etc/ceph

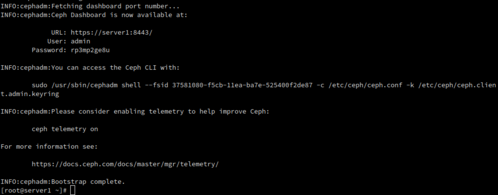

Vamos iniciar o deploy com "cepham bootstrap --mon-ip" e o "ip one" será o nosso monitor, que no caso é o server 1:

# cephadm bootstrap --mon-ip 192.168.122.11 Vamos criar um alias do cephadm shell, somente para Ceph para facilitar o trabalho:

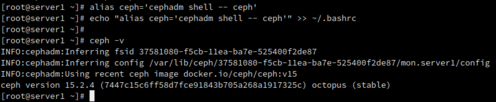

# alias ceph='cephadm shell -- ceph'

# echo "alias ceph='cephadm shell -- ceph'" >> ~/.bashrc Ceph rodando em contêiner no podman:

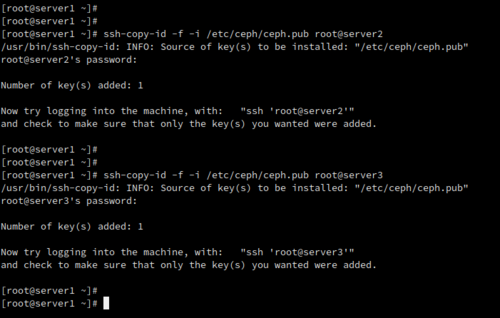

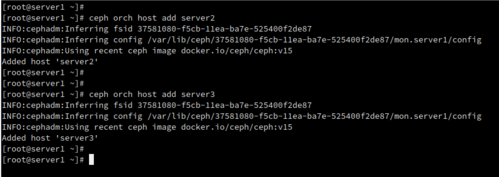

Agora vamos adicionar os Server2 e Server3. Copie a chave publica do SSH para os servers:

# ssh-copy-id -f -i /etc/ceph/ceph.pub root@server2

# ssh-copy-id -f -i /etc/ceph/ceph.pub root@server3 Vamos add os servers ao cluster:

# ceph orch host add server2

# ceph orch host add server3 Podemos verificar se esta ok:

# ceph orch host ls Verifica os device que vamos utilizar para o Ceph, se esta em "True" (AVAIL = True):

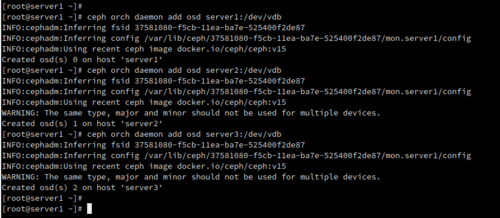

# ceph orch device ls Vamos configurar os OSD em cada hosts:

# ceph orch daemon add osd server1:/dev/vdb

# ceph orch daemon add osd server2:/dev/vdb

# ceph orch daemon add osd server3:/dev/vdb Espere por alguns minutos e podemos verificar o status:

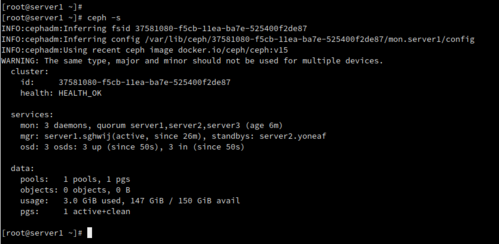

# ceph -s

2. Instalação

3. Configuração

aaPanel - Um Painel de Hospedagem Gratuito e Poderoso

FreeIPA - uma solução integrada de identidade e autenticação para ambientes de rede Linux/UNIX

Rocky Linux - Novo Substituto do CentOS

Trilha Filesystems Linux - Operação de Sistemas de Arquivos

Checando seu sistema de arquivos com fsck

Alta disponibilidade: CentOS 6 - configurando os pacotes DRBD com gfs2 - parte 1

Montando um servidor Linux com sshfs no SuSE

GmailFS - sua conta de e-mail como um sistema de arquivos no Slackware 10.2

Muito bom.

___________________________________________________________

[code]Conhecimento não se Leva para o Túmulo.

https://github.com/MauricioFerrari-NovaTrento [/code]

Patrocínio

Destaques

Artigos

Papagaiando o XFCE com temas e recursos

WhatsApp com Chamadas no Linux via Waydroid

XFCE - quase um Gnome ou Plasma mas muito mais leve

LXQT - funcional para máquinas pererecas e usuários menos exigentes

Dicas

Atualizações de Segurança Automáticas no Debian

Como cortar as partes de um vídeo com passagens de áudio em branco

Tiling automático no KDE Plasma

SNMP Scan no OCS Inventory só funciona com HTTPS corretamente configurado

Tópicos

Alguém tem que acabar com ANATEL!!! (1)

Reflexão sobre a sobrevivência do Gentoo Linux (0)

GOG confirma suporte oficial ao sistema Linux: "o trabalho começo... (4)

Top 10 do mês

-

Xerxes

1° lugar - 122.935 pts -

Fábio Berbert de Paula

2° lugar - 58.169 pts -

Buckminster

3° lugar - 27.700 pts -

Mauricio Ferrari (LinuxProativo)

4° lugar - 19.668 pts -

Alberto Federman Neto.

5° lugar - 19.428 pts -

Alessandro de Oliveira Faria (A.K.A. CABELO)

6° lugar - 18.820 pts -

Daniel Lara Souza

7° lugar - 18.393 pts -

edps

8° lugar - 18.045 pts -

Sidnei Serra

9° lugar - 17.462 pts -

Andre (pinduvoz)

10° lugar - 16.727 pts